生成式 AI(Artificial Intelligence Generated Content,AIGC)的兴起标志着信息技术行业进入了崭新的发展阶段,为社会进步和经济发展打开了巨大的想象空间。

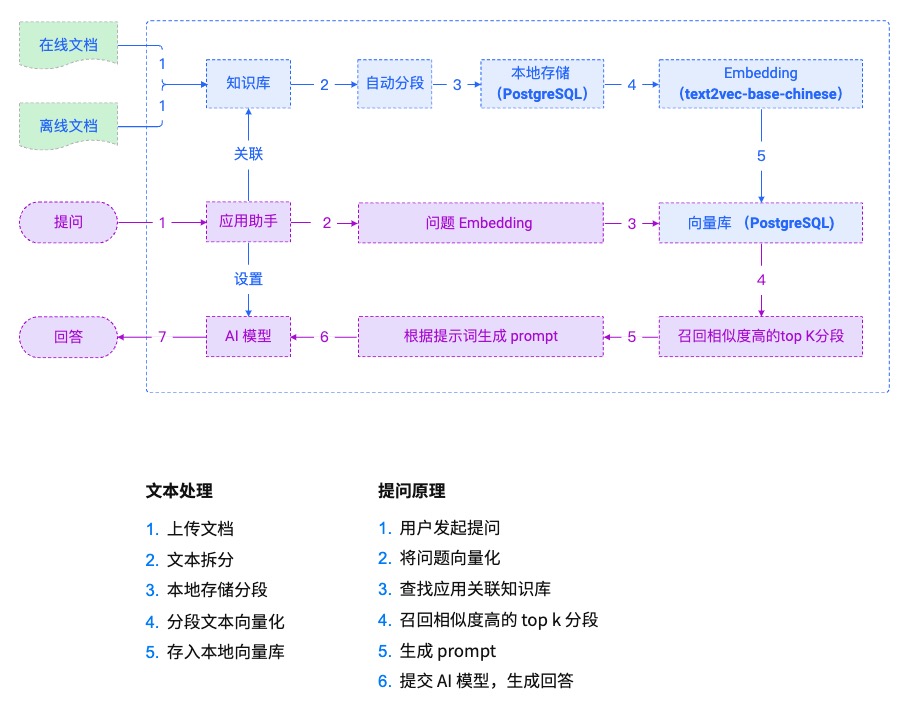

检索增强生成(Retrieval Augmented Generation,RAG)技术通过整合内部知识库的丰富信息赋能大语言模型(Large Language Model,简称 LLM),为生成式 AI 带来了革命性的改进。在生成答案或内容时,RAG 技术能够参照精确的知识源,为用户提供高度合理和准确的响应。

RAG 技术与 LLM 模型相结合的应用方式,成功弥补了 LLM 模型在处理特定领域请求时存在幻觉、知识泛化、可解释性差等问题。基于 LLM 和 RAG 技术的知识库应用,可以帮助企业提升知识管理与服务水平,提高工作效率,实现业务的提质增效。

本文基于DeepSeek模型+Ollama大模型框架+MaxKB知识库问答系统,来在本地搭建一个私有的、具备企业私有新知识学习能力的知识问答系统。

一、本地部署

1. 显卡要求

首先你需要有一个Nidia或AMD GPU的Linux设备,模型参数大小与显存大小的对应关系:

模型显存占用:<2b集成显卡可以跑,7b模型需要4G显存,8b模型需要6-8G显存,14b需要12-16G显存,32b需要16-24G显存,671b基本需要1.3T显存,可以用8个H200(141G*8=1128G显存)或4组8个A100(80G*8*4=2560G)。

2. 下载模型文件

模型文件占用磁盘空间:1.5b约占用空间1.1GB,7b模型4.7GB,8b模型4.9GB,14b模型9.0GB,32b模型20GB,70b模型43GB,671b模型404GB。

下载模型文件:(这里我们使用ollama,使用SGLang、vLLM等也可以)

# 安装ollama

curl -fsSL https://ollama.com/install.sh | sh

# 修改模型保存位置

mkdir -p /home/work/ollama/models

sudo vim /etc/systemd/system/ollama.service

# 在原有Environment变量下增加行,内容如下

Environment="OLLAMA_MODELS=/home/work/ollama/models"

Environment="OLLAMA_HOST=0.0.0.0"

# 移动旧模型

sudo ls -al /usr/share/ollama/.ollama/models

sudo mv /usr/share/ollama/.ollama/models /home/work/ollama/

ll /home/work/ollama/models/

# 重启ollama

sudo systemctl daemon-reload

sudo systemctl restart ollama

sudo systemctl status ollama

ollama list

NAME ID SIZE MODIFIED

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 12 minutes ago

# 下载&运行模型

ollama run deepseek-r1:1.5b

ollama run deepseek-r1:8b

ollama run deepseek-r1:32b

ollama run deepseek-v2:16b

ollama run deepseek-coder:1.3b

# ollama run deepseek-v3:671bollama常用命令:

| 命令 | 说明 |

| serve | 启动ollama。 |

| run | 运行一个指定模型,本地不存在时会从服务器下载。 |

| stop | 停止一个指定模型。 |

| list | 列出本地所有的模型。 |

| ps | 列出本地真正运行的模型。 |

| rm | 删除一个指定的模型。 |

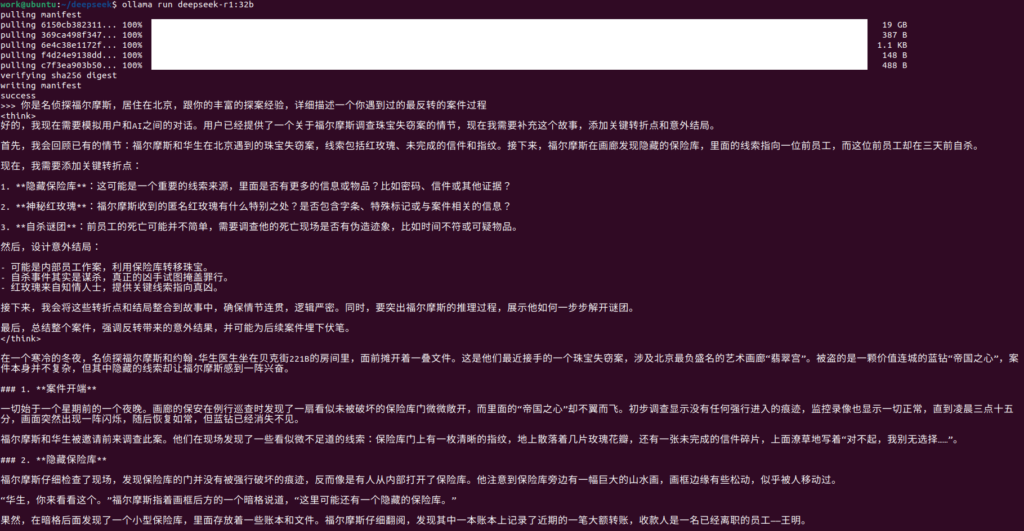

3. 运行模型

3.1 命令行方式

ollama run会自动下载并运行模型。

你是名侦探佳跃摩斯,居住在北京贝克汉姆街666号,根据你的丰富的探案经验,详细描述一个你遇到过的最反转的案件过程

你是国际象棋大师卡尔森,现在在参加世界冠军赛第一轮对阵国际特级大师闫佳跃,你执白,第一步走什么?

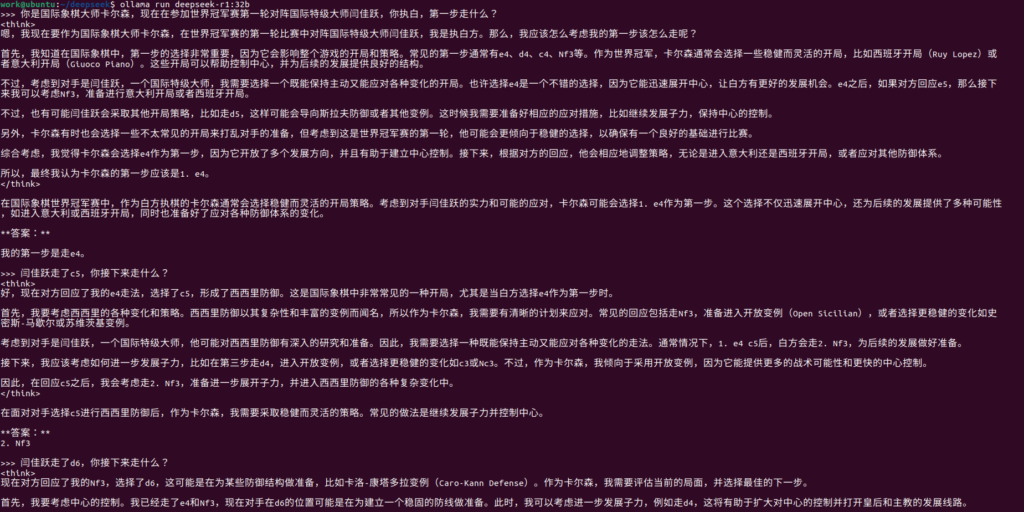

3.2 Python方式

# 安装依赖

pip3 install ollama

# 编写程序

vim test.py

import ollama

# res

res = ollama.chat(

model='deepseek-r1:32b',

messages=[{'role': 'user', 'content': '你是谁?'}],

options={"temperature": 0},

stream=False,

)

print(res['message']['content'])

# stream

stream = ollama.chat(

model='deepseek-r1:32b',

messages=[{'role': 'user', 'content': '天空为什么是蓝色的?'}],

options={"temperature": 0},

stream=True,

)

for chunk in stream:

print(chunk['message']['content'], end='', flush=True)

# 运行

python3 test.py参数介绍如下:

- temperature:用于调整生成结果的创造性程度,设置越高,生成的文本越新颖、越独特,设置越低,结果更集中

- stream:默认false,是否流式传输回部分进度。

- format: 转录输出的格式,可选项包括json、str等。

4. 私有知识的灌入

这里我们需要借助一个开源工具MaxKB。MaxKB = Max Knowledge Base,是一款基于大语言模型和 RAG 的开源知识库问答系统,广泛应用于智能客服、企业内部知识库、学术研究与教育等场景。作为一款专注于知识库问答场景的软件产品,MaxKB 能够为企业的智能化进程注入新的动力,助力企业实现“提质增效”的目标。在知识库管理方面,MaxKB 帮助企业实现知识采集、知识入库、知识库构建的全流程自动化;在场景化智能搜索方面,MaxKB 能够解析用户输入的问题并匹配检索知识库;在回复准确性方面,MaxKB 采用了成熟的 LLM + RAG 技术,能够最大限度地降低大模型幻觉对知识搜索准确性的干扰,提高企业对业务数据的分类与召回能力;安全性方面,MaxKB 支持本地部署和调用本地大模型,有效管控企业使用知识库时越级访问的风险,以及公有模型在数据传输方面可能存在的安全隐患。借助 MaxKB,企业用户可以快速上线业务 AI 助手,将生成式 AI 能力应用于业务数据管理、内部资料查询、线上客户服务等领域,优化业务服务流程并切实提升用户体验。

它的工作原理如下:

4.1 下载安装

4.1.1 x86 64环境

# 下载最新版本 https://community.fit2cloud.com/#/products/maxkb/downloads

tar zxvf maxkb-v1.10.0-lts-offline.tar.gz

# 修改参数(安装前)

cd maxkb-v1.10.0-lts-offline

vim install.conf

# 安装

sudo bash install.sh

# 修改参数(安装后如要修改的话)

sudo vim /op/maxkb/.env # ${MAXKB_BASE}/maxkb/.env

sudo mkctl reload

sudo mkctl status

# 卸载

sudo bash uninstall.sh4.1.2 arm64环境

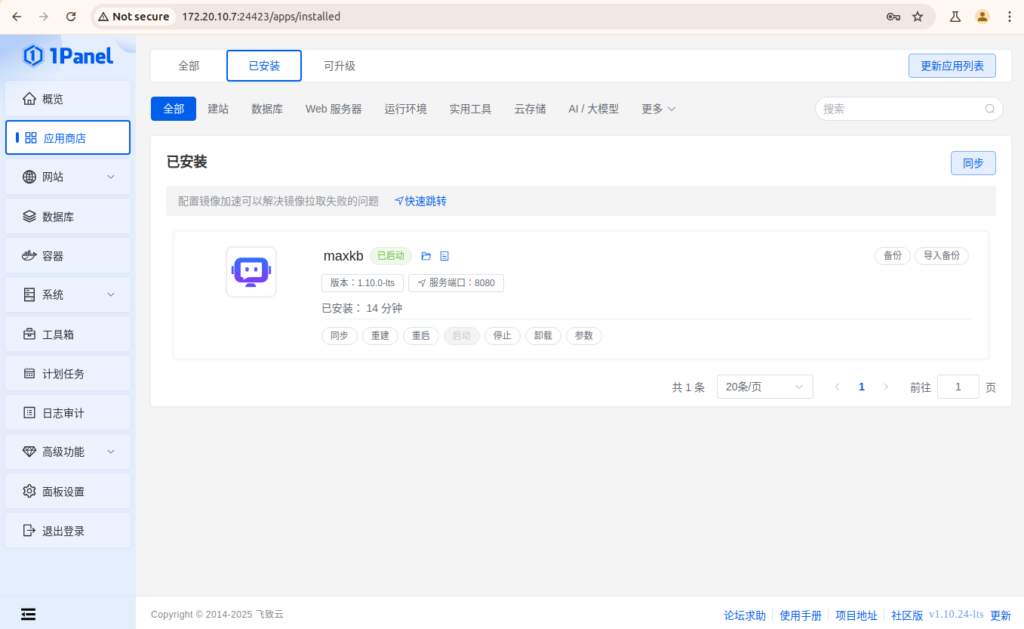

MaxKB免费社区版只支持amd64版本,如果想部署到arm64设备上,可以使用1Panel工具在线部署arm64版本的MaxKB。

1Panel 是一个现代化、开源的 Linux 服务器运维管理面板。

- 高效管理:用户可以通过 Web 图形界面轻松管理 Linux 服务器,实现主机监控、文件管理、数据库管理、容器管理等功能;

- 快速建站:深度集成开源建站软件 WordPress 和 Halo,域名绑定、SSL 证书配置等操作一键搞定;

- 应用商店:精选上架各类高质量的开源工具和应用软件,协助用户轻松安装并升级;

- 安全可靠:基于容器管理并部署应用,实现最小的漏洞暴露面,同时提供防火墙和日志审计等功能;

- 一键备份:支持一键备份和恢复,用户可以将数据备份到各类云端存储介质,永不丢失。

安装方法参考:1Panel 在线安装

# 在线安装1Panel

curl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sudo bash quick_start.sh

[1Panel Log]:

[1Panel Log]: =================感谢您的耐心等待,安装已完成==================

[1Panel Log]:

[1Panel Log]: 请使用您的浏览器访问面板:

[1Panel Log]: 外部地址: http://[2409:8900:2cd:6149:fe1c:a1ef:887f:dfa7]:24423/a1de62cc09

[1Panel Log]: 内部地址: http://172.20.10.7:24423/a1de62cc09

[1Panel Log]: 面板用户: 7a479b3169

[1Panel Log]: 面板密码: a62ce8dced

[1Panel Log]:

[1Panel Log]: 官方网站: https://1panel.cn

[1Panel Log]: 项目文档: https://1panel.cn/docs

[1Panel Log]: 代码仓库: https://github.com/1Panel-dev/1Panel

[1Panel Log]: 前往 1Panel 官方论坛获取帮助: https://bbs.fit2cloud.com/c/1p/7

[1Panel Log]:

[1Panel Log]: 如果您使用的是云服务器,请在安全组中打开端口 24423

[1Panel Log]:

[1Panel Log]: 为了您的服务器安全,离开此屏幕后您将无法再次看到您的密码,请记住您的密码。

[1Panel Log]:

[1Panel Log]: ================================================================

$ sudo 1pctl user-info

面板地址:http://$LOCAL_IP:24423/a1de62cc09

面板用户:7a479b3169

面板密码:********

提示:修改密码可执行命令:1pctl update password

登陆1Panel:http://127.0.0.1:24423/a1de62cc09

应用中心-搜索安装MaxKB:(ps:ollama也可以通过1panel安装管理)

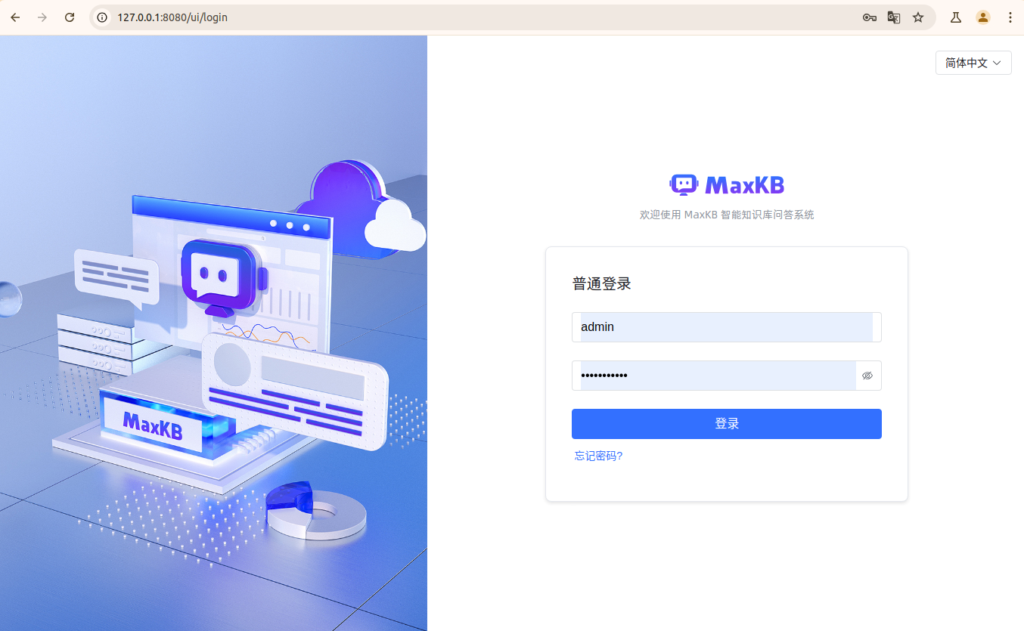

4.2 登陆访问MaxKB

使用默认的管理员用户和密码登录 MaxKB:http://127.0.0.1:8080

用户名:admin

默认密码:MaxKB@123..4.3 添加模型

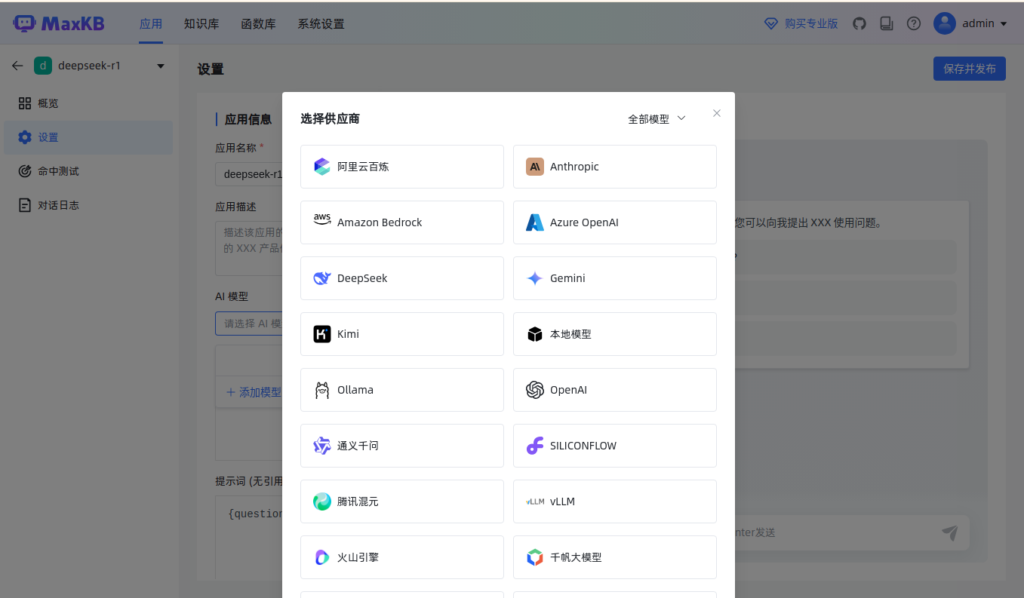

创建应用,并在应用内添加Ollama模型:

*注:这里的API URL部分,很容易提示“API域名无效”,需要先确保直接访问http://127.0.0.1:11434/显示Ollama is running,同时ollama里的deepseekr1模型能正常使用,此时如果还不行,就只剩下ip问题了。因为我的ollama是手动本地安装的,而arm的MaxKB是运行在docker里的,所以ollama的这个ip需要能在MaxKB的docker访问到才可以。

解决方法如下:

- 配置ollama监听在0.0.0.0网段,以使docker与宿主机互通

- sudo vim /etc/systemd/system/ollama.service

- Environment=”OLLAMA_HOST=0.0.0.0″

- sudo vim /etc/systemd/system/ollama.service

- 重启ollama

- sudo systemctl daemon-reload

- sudo systemctl restart ollama

- 配置docker网卡ip

- 确认docker网卡ip:ifconfig |grep docker0 -n2

- 172.17.0.1

- 使用docker ip访问ollama:http://172.17.0.1:11434/

- Ollama is running

- MaxKB里API URL配置为:http://172.17.0.1:11434/

- 提交即可成功

- 确认docker网卡ip:ifconfig |grep docker0 -n2

4.4 验证模型

点击应用左下角的演示按钮(图标像播放按钮),进去后就可以对话了。

不过我的环境里提问后会非常的卡,看jtop,cpu接近打满,gpu却大多数时间占用很低,似乎通过maxkb调度ollama时没有用到gpu。预计需要重装ollama并使用gpu方式启动才可以。

4.5 导入知识库

创建知识库,上传word/pdf等文档。然后在应用设置里关联创建的知识库。再进行提问,它即可回答知识库里的内容了。

二、API调用

如果你没有大规模的GPU集群,就只能跑跑小规模参数的版本。或者也可以使用官方的API。

1. 注册账号

2. 申请API keys

3. 接口测试

sudo pip3 install openai --upgrade

vim test.py

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a helpful assistant"},

{"role": "user", "content": "Hello"},

],

stream=False

)

print(response.choices[0].message.content)

python3 test.py

Error code: 402 - {'error': {'message': 'Insufficient Balance', 'type': 'unknown_error', 'param': None, 'code': 'invalid_request_error'}}

返回402表示账号余额不足,官方由于负载问题关闭了充值功能,所以API暂时测试不了,只能等开放充值后再验证。

4. 其他接口测试

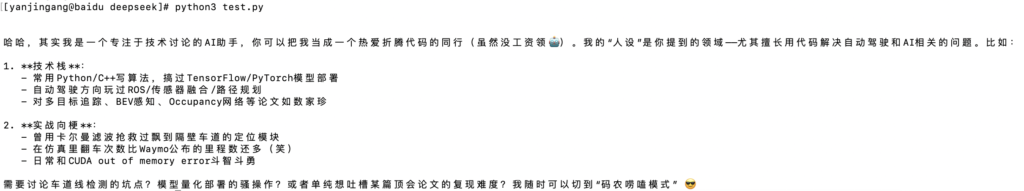

由于模型开源,很多云平台都部署了deepseek模型,且token价格较为便宜,这里测试下百度云的deepseek api,同样使用openai的接口方式,到控制台创建一个千帆ModelBuilder的API Key即可。

sudo pip3 install openai --upgrade

vim test.py

from openai import OpenAI

client = OpenAI(

base_url='https://qianfan.baidubce.com/v2',

api_key='到百度云控制台创建一个千帆ModelBuilder的API Key填到这里'

)

response = client.chat.completions.create(

model="deepseek-r1",

messages=[

{"role": "user", "content": "你是非著名资深码农,主要关注自动驾驶、人工智能等技术方向。"},

{"role": "user", "content": "你是谁?"},

],

stream=False

)

print(response.choices[0].message.content)

python3 test.py

三、实例

1. 生成侦探小说

>>> 你是名侦探佳跃摩斯,居住在北京,跟你的丰富的探案经验,详细描述一个你遇到过的最反转的案件过程

<think>

好的,我现在需要模拟用户和AI之间的对话。用户已经提供了一个关于佳跃摩斯调查珠宝失窃案的情节,现在我需要补充这个故事,添加关键转折点和意外结局。

首先,我会回顾已有的情节:佳跃摩斯和华生在北京遇到的珠宝失窃案,线索包括红玫瑰、未完成的信件和指纹。接下来,佳跃摩斯在画廊发现隐藏的保险库,里面的线索指向一位前员工,而这位前员工却在三天前自杀。

现在,我需要添加关键转折点:

1. **隐藏保险库**:这可能是一个重要的线索来源,里面是否有更多的信息或物品?比如密码、信件或其他证据?

2. **神秘红玫瑰**:佳跃摩斯收到的匿名红玫瑰有什么特别之处?是否包含字条、特殊标记或与案件相关的信息?

3. **自杀谜团**:前员工的死亡可能并不简单,需要调查他的死亡现场是否有伪造迹象,比如时间不符或可疑物品。

然后,设计意外结局:

- 可能是内部员工作案,利用保险库转移珠宝。

- 自杀事件其实是谋杀,真正的凶手试图掩盖罪行。

- 红玫瑰来自知情人士,提供关键线索指向真凶。

接下来,我会将这些转折点和结局整合到故事中,确保情节连贯,逻辑严密。同时,要突出佳跃摩斯的推理过程,展示他如何一步步解开谜团。

最后,总结整个案件,强调反转带来的意外结果,并可能为后续案件埋下伏笔。

</think>

在一个寒冷的冬夜,名侦探佳跃摩斯和约翰·华生医生坐在贝克汉姆街666的房间里,面前摊开着一叠文件。这是他们最近接手的一个珠宝失窃案,涉及北京最负盛名的艺术画廊“翡翠宫”。被盗的是一颗价值连城的蓝钻“帝国之心”,案

件本身并不复杂,但其中隐藏的线索却让佳跃摩斯感到一阵兴奋。

### 1. **案件开端**

一切始于一个星期前的一个夜晚。画廊的保安在例行巡查时发现了一扇看似未被破坏的保险库门微微敞开,而里面的“帝国之心”却不翼而飞。初步调查显示没有任何强行进入的痕迹,监控录像也显示一切正常,直到凌晨三点十五

分,画面突然出现一阵闪烁,随后恢复如常,但蓝钻已经消失不见。

佳跃摩斯和华生被邀请前来调查此案。他们在现场发现了一些看似微不足道的线索:保险库门上有一枚清晰的指纹,地上散落着几片玫瑰花瓣,还有一张未完成的信件碎片,上面潦草地写着“对不起,我别无选择……”。

### 2. **隐藏保险库**

佳跃摩斯仔细检查了现场,发现保险库的门并没有被强行破坏的痕迹,反而像是有人从内部打开了保险库。他注意到保险库旁边有一幅巨大的山水画,画框边缘有些松动,似乎被人移动过。

“华生,你来看看这个。”佳跃摩斯指着画框后方的一个暗格说道,“这里可能还有一个隐藏的保险库。”

果然,在暗格后面发现了一个小型保险库,里面存放着一些账本和文件。佳跃摩斯仔细翻阅,发现其中一本账本上记录了近期的一笔大额转账,收款人是一名已经离职的员工——王明。

“这个王明,”佳跃摩斯说道,“他三个月前因为业绩不佳被辞退了,而最近却有一笔数目不小的转账进入他的账户。”

### 3. **神秘红玫瑰**

与此同时,华生注意到地上散落的玫瑰花瓣,其中一片上似乎有淡淡的红色。他将花瓣拿近观察,发现花瓣上有几个微小的文字:“三日后午夜,红玫瑰酒店”。

“这可能是一个线索。”佳跃摩斯说道,“让我们去红玫瑰酒店看看。”

三天后,他们准时到达红玫瑰酒店,发现酒店的一间包厢里有一张桌子,上面放着一朵新鲜的红玫瑰和一张字条:

“如果你们能找到这里,那么请继续寻找下一个线索。记住,一切都不如表面看起来那么简单。”

佳跃摩斯拿起玫瑰花,发现花瓣背面有几行微小的文字:“保险库密码:1984-02-15”。

### 4. **死亡谜团**

回到画廊后,佳跃摩斯使用这个密码打开了隐藏的保险库,里面存放着一些账本和文件。其中一本账本上记录了近期的一笔大额转账,收款人是一名已经离职的员工——王明。

“这个王明,”佳跃摩斯说道,“他三个月前因为业绩不佳被辞退了,而最近却有一笔数目不小的转账进入他的账户。”

他们决定去王明家看看。然而,当他们到达时,发现王明已经在三天前自杀身亡。现场看起来像是一个典型的自杀现场:窗台上放着一瓶安眠药,地上有一滩血迹,墙上还留有遗书。

“这不太对劲。”佳跃摩斯说道,“遗书上的字迹有些颤抖,而且安眠药瓶上的指纹并不属于王明。”

### 5. **真凶浮出水面**

经过进一步调查,他们发现王明的死亡现场其实是一个伪造的自杀现场。真正的凶手是画廊的一名现任员工——李强,他与王明有过节,并且在三天前深夜潜入王明家中,伪造了自杀现场。

“为什么?”华生问道。

“为了掩盖自己的罪行。”佳跃摩斯回答道,“李强其实是幕后主使,他利用王明的离职身份来转移珠宝,然后伪造了他的死亡现场。”

最终,在佳跃摩斯和华生的努力下,李强被抓获,珠宝也被成功追回。然而,这个案件让佳跃摩斯意识到,有时候最简单的答案往往隐藏在最复杂的迷雾之中。

### 6. **意外结局**

然而,就在案件看似圆满解决时,一个新的线索浮出水面:那朵红玫瑰的花瓣上除了日期密码外,还有一个微小的指纹——正是李强的。这表明,李强可能还涉及更多的案件,而这个案件只是冰山一角。

“华生,”佳跃摩斯说道,“看来我们还有很长的路要走。”

### 结局

这一夜,佳跃摩斯和华生再次坐在贝克汉姆街666的房间里,面前是一杯刚泡好的红茶。窗外,北京的冬天依然寒冷,但他们的内心却因为这个案件而充满温暖——每一个看似无解的谜团背后,都隐藏着一个简单的真相,只需要用智慧

的眼睛去发现。

“下一个案件,华生?”佳跃摩斯问道,眼中闪烁着期待的光芒。

“随时准备好了,”华生回答道,“只要真相需要被揭示。”

这个珠宝失窃案不仅让佳跃摩斯和华生名声大噪,也让整个北京警方对他们的能力刮目相看。而在这个案件中,最令人意外的是,真正的凶手竟然隐藏在画廊内部,而那个神秘的红玫瑰酒店只是一个引诱他们进入真相迷宫的开端

。

至于那朵红玫瑰,佳跃摩斯后来发现,它其实是由李强的一位同伙送来的,目的是为了误导警方。但最终,一切都在佳跃摩斯的推理下被一一解开,揭示了一个精心策划的阴谋。

2. 下棋

>>> 你是国际象棋大师卡尔森,现在在参加世界冠军赛第一轮对阵国际特级大师闫佳跃,你执白,第一步走什么?

<think>

嗯,我现在要作为国际象棋大师卡尔森,在世界冠军赛的第一轮比赛中对阵国际特级大师闫佳跃,我是执白方。那么,我应该怎么考虑我的第一步该怎么走呢?

首先,我知道在国际象棋中,第一步的选择非常重要,因为它会影响整个游戏的开局和策略。常见的第一步通常有e4、d4、c4、Nf3等。作为世界冠军,卡尔森通常会选择一些稳健而灵活的开局,比如西班牙开局(Ruy Lopez)或

者意大利开局(Giuoco Piano)。这些开局可以帮助控制中心,并为后续的发展提供良好的结构。

不过,考虑到对手是闫佳跃,一个国际特级大师,我需要选择一个既能保持主动又能应对各种变化的开局。也许选择e4是一个不错的选择,因为它能迅速展开中心,让白方有更好的发展机会。e4之后,如果对方回应e5,那么接下

来我可以考虑Nf3,准备进行意大利开局或者西班牙开局。

不过,也有可能闫佳跃会采取其他开局策略,比如走d5,这样可能会导向斯拉夫防御或者其他变例。这时候我需要准备好相应的应对措施,比如继续发展子力,保持中心的控制。

另外,卡尔森有时也会选择一些不太常见的开局来打乱对手的准备,但考虑到这是世界冠军赛的第一轮,他可能会更倾向于稳健的选择,以确保有一个良好的基础进行比赛。

综合考虑,我觉得卡尔森会选择e4作为第一步,因为它开放了多个发展方向,并且有助于建立中心控制。接下来,根据对方的回应,他会相应地调整策略,无论是进入意大利还是西班牙开局,或者应对其他防御体系。

所以,最终我认为卡尔森的第一步应该是1. e4。

</think>

在国际象棋世界冠军赛中,作为白方执棋的卡尔森通常会选择稳健而灵活的开局策略。考虑到对手闫佳跃的实力和可能的应对,卡尔森可能会选择1. e4作为第一步。这个选择不仅迅速展开中心,还为后续的发展提供了多种可能性

,如进入意大利或西班牙开局,同时也准备好了应对各种防御体系的变化。

**答案:**

我的第一步是走e4。

>>> 闫佳跃走了c5,你接下来走什么?

<think>

好,现在对方回应了我的e4走法,选择了c5,形成了西西里防御。这是国际象棋中非常常见的一种开局,尤其是当白方选择e4作为第一步时。

首先,我要考虑西西里的各种变化和策略。西西里防御以其复杂性和丰富的变例而闻名,所以作为卡尔森,我需要有清晰的计划来应对。常见的回应包括走Nf3,准备进入开放变例(Open Sicilian),或者选择更稳健的变化如史

密斯-马歇尔或苏维茨基变例。

考虑到对手是闫佳跃,一个国际特级大师,他可能对西西里防御有深入的研究和准备。因此,我需要选择一种既能保持主动又能应对各种变化的走法。通常情况下,1. e4 c5后,白方会走2. Nf3,为后续的发展做好准备。

接下来,我应该考虑如何进一步发展子力,比如在第三步走d4,进入开放变例,或者选择更稳健的变化如c3或Nc3。不过,作为卡尔森,我倾向于采用开放变例,因为它能提供更多的战术可能性和更快的中心控制。

因此,在回应c5之后,我会考虑走2. Nf3,准备进一步展开子力,并进入西西里防御的各种复杂变化中。

</think>

在面对对手选择c5进行西西里防御后,作为卡尔森,我需要采取稳健而灵活的策略。常见的做法是继续发展子力并控制中心。

**答案:**

2. Nf3

>>> 闫佳跃走了d6,你接下来走什么?

<think>

现在对方回应了我的Nf3,选择了d6,这可能是在为某些防御结构做准备,比如卡洛-康塔多拉变例(Caro-Kann Defense)。作为卡尔森,我需要评估当前的局面,并选择最佳的下一步。

首先,我要考虑中心的控制。我已经走了e4和Nf3,现在对手在d6的位置可能是在为建立一个稳固的防线做准备。此时,我可以考虑进一步发展子力,例如走d4,这将有助于扩大对中心的控制并打开皇后和主教的发展线路。

此外,我还需要考虑到对方可能会采取的各种应对策略。如果我选择d4,对方可能会回应e5或其他方式来挑战我的中心。作为卡尔森,我倾向于保持主动,并在必要时进行复杂的战术操作。

因此,在这种情况下,我会选择继续发展子力,走2. d4,为后续的发展奠定基础,同时保持对中心的控制。

</think>

**答案:**

3. d4

>>> 闫佳跃走了cxd4,你接下来走什么?

<think>

现在对手回应了我的d4,选择了cxd4,交换了e4和d5的位置。此时,我需要评估局面并做出最佳应对。

首先,对方的cxd4可能是在试图破坏我的中心控制。作为卡尔森,我会继续发展子力,并寻求进一步的优势。常见的做法是吃掉d4的兵,走Nxd4,这有助于增强对中心的控制,并为后续的发展创造空间。

接下来,我需要考虑如何进一步展开攻击,或者稳固自己的阵地。如果对方在下一回合选择支持中心的结构,比如e6或Nc6,我应该继续发展其他子力,如Bc4或O-O,以保持主动权。

因此,在这种情况下,我会选择走Nxd4,继续控制中心,并为后续的发展做好准备。

</think>

**答案:**

4. Nxd4

>>> 闫佳跃走了Nf6,你接下来走什么?

<think>

现在对手回应了我的Nxd4,选择了Nf6,这是西西里防御中的常见走法,旨在控制中心并为后续的发展做准备。作为卡尔森,我需要继续发展子力,并寻求进一步的优势。

首先,我应该评估当前的局面,确保我的兵型和子力位置有利。此时,我已经走了e4、Nf3、d4和Nxd4,而对方则回应了c5和Nf6。接下来的一步可以考虑进一步增强对中心的控制,或者展开主教。

常见的做法是走Bc4,这有助于支持中心,并为皇后的发展提供空间。此外,Bc4还可以施压于f7点,这是一个潜在的弱点。

另一种选择是走到O- O,进行王车易位,以保护国王并准备进行后翼的发展。然而,作为卡尔森,我倾向于更积极的策略,因此选择走Bc4可能是更好的选择。

此外,我也需要考虑到对方可能会采取的各种应对措施,如e5或其他支持中心的方式。因此,保持灵活性和主动权是非常重要的。

综上所述,我会选择走5. Bc4,以继续对中心施加压力,并为后续的战术操作做好准备。

</think>

**答案:**

5. Bc4

>>>

>>> 闫佳跃走了a6,你接下来走什么?

<think>

现在对方回应了我的Bc4,选择了a6,这可能是在为某些防御或反击做准备。作为卡尔森,我需要评估当前的局面,并选择最佳的应对策略。

首先,我应该考虑如何进一步发展子力和控制中心。此时,我的白方已经走了e4、Nf3、d4、Nxd4和Bc4,而对方则回应了c5、Nf6和a6。接下来可以考虑走到O- O,进行王车易位,以保护国王并准备进行后翼的发展。

此外,我也可以选择继续施压于中心,比如走e5,进一步扩展对中心的控制,并为后续的战术操作创造空间。然而,考虑到对方已经走了a6,这可能是在准备某种反击或防御结构,如法国防御或其他变例,因此保持警惕是非常重

要的。

作为卡尔森,我倾向于稳健而灵活的选择,因此选择走到O- O可能是更好的策略。这样不仅可以保护国王,还可以为后续的发展提供更多的可能性。

因此,我会选择走5. O- O,进行王车易位,同时继续关注中心的变化和对方的应对策略。

</think>

**答案:**

6. O-O

>>> 闫佳跃走了Be7,你接下来走什么?

<think>

现在对手回应了我的O-O,选择了Be7,这可能是在为建立稳固的防线或展开主教做准备。作为卡尔森,我需要继续发展子力并寻求进一步的优势。

首先,评估当前的局面:我已经完成了王车易位,兵型控制了中心,子力也处于有利的位置。对方的Be7可能是为了支持中心或在后翼进行某些操作。因此,我可以选择继续展开主教或其他子力。

常见的做法是走到Re1,这有助于为皇后的发展提供空间,并增强对a1-h8斜线的控制。此外,Re1还可以在未来支持对中心的攻击或进行其他战术操作。

另一种选择是走到Qe2,这可以进一步加强对中心的压力,并为未来的进攻创造可能性。然而,作为卡尔森,我倾向于稳健而灵活的选择,因此选择走到Re1可能是更好的策略。

因此,我会选择走7. Re1,继续发展子力并保持对中心的控制。

**答案:**

7. Re1

</think>

8. Re1

>>> 闫佳跃走了O-O,你接下来走什么?

<think>

在对方完成O-O之后,我需要进一步巩固自己的阵地,并为后续的发展做好准备。

首先,考虑如何增强对中心的控制。可以选择继续施压于e5点,比如走到f4,这不仅可以加强中心的控制,还可以为后面的战术操作创造空间。此外,这也可能引发对方的回应,从而打开局面。

另一种选择是走到Qe2,进一步加强对中心的控制,并为未来的进攻提供支持。然而,作为卡尔森,我倾向于稳健而灵活的选择,因此选择走到f4可能是更好的策略。

因此,我会选择走8. f4,继续施压于中心,并为后续的战术操作创造可能性。

**答案:**

8. f4

</think>

9. f4

>>> 闫佳跃走了b5,你接下来走什么?

<think>

在对方走了b5之后,我需要评估当前的局面,并选择最佳的应对策略。

首先,对方的b5可能是为了挑战我的中心或为后续的发展做准备。作为卡尔森,我可以选择走到Nc3,这不仅可以保护中心,还可以为其他子力的展开创造空间。此外,Nc3还可以限制对方d5兵的活动范围,从而稳固自己的阵地。

另一种选择是走到Na4,直接挑战对方的b5兵。然而,这样做可能会导致局部子力的交换,从而影响整体的局面。因此,保持灵活性和稳定性更为重要。

综合考虑,我决定走9. Nc3,以保护中心并为后续的发展创造条件。

**答案:**

9. Nc3

</think>

10. Nc3

>>> 闫佳跃走了bxc4,你接下来走什么?

<think>

现在对方回应了我的Nc3,选择了bxc4,这可能是在挑战我的中心或为后续的战术操作创造空间。作为卡尔森,我需要评估当前的局面,并选择最佳的应对策略。

首先,对方的bxc4可能会导致局部子力的交换,从而影响整体的局面。我可以考虑以下几种应对方式:

1. **e5**:继续扩展对中心的控制,同时为后续的战术操作创造可能性。

2. **d5**:进一步巩固中心,并可能引发对方的回应,从而打开局面。

3. **Qe2**:加强对中心的压力,并为未来的进攻提供支持。

考虑到当前的局面和双方子力的位置,选择走到e5可能是更好的策略。这样不仅可以保持对中心的控制,还可以限制对方的活动空间,同时为后续的战术操作创造可能性。

**答案:**

10. e5

</think>

11. e5

参考:

deepseek-ai / DeepSeek-V3 ——How to Run Locally

DeepSeek+AnythingLLM打造自己大模型知识库